在已往 的一年中,语音辨认 再次取得非常大的突破。IBM、微软等多家机构相继推出了本身 的 Deep CNN 模子 ,提拔 了语音辨认 的正确 率;Residual/Highway 网络的提出使我们可以把神经网络练习 的更加深。

而诸如 CTC、Low Frame Rate、Chain 模子 等粗粒度建模单位 技能 使得语音辨认 正确 率得到提拔 的同时,解码速率 也可以大大加快 。

本期雷锋网硬创公开课特邀供职于阿里巴巴 iDST 的语音专家薛少飞博士,从学术的角度回顾 已往 一段时间里语音辨认 技能 的盼望 。

高朋 先容 :

薛少飞,阿里巴巴 iDST 语音辨认 专家,中国科学技能 大学博士。现负责阿里声学模子 研究与应用:包罗 语音辨认 声学建模和深度学习在业务场景中的应用。博士期间的研究方向为语音辨认 语言 人自顺应 ,提出基于 Speaker Code 的模子 域自顺应 方法,在语音相干 的集会 会议 和期刊上发表论文十余篇。

本期公开课的分享重要 包罗 三大部分 :

深度神经网络声学模子 发展回顾 :简单 回顾 深度神经网络技能 在语音辨认 声学模子 中的应用汗青 ;

前沿声学模子 技能 盼望 :近期几个比力 故意 思的声学模子 技能 盼望 ,包罗 Deep CNN 技能 、Residual/Highway 网络技能 和粗粒度建模单位 技能 。固然 这里并没有把全部 的新技能 盼望 都席卷 进来,比如 Attention 技能 。只是以这三条线路为例看看语 音辨认 声学模子 技能 的盼望 和将来 的发展趋势。

阿里巴巴的语音辨认 声学模子 技能 。

一、深度神经网络声学模子 发展回顾

回顾 语音辨认 技能 的发展汗青 可以看到,自从上世纪 90 年代语音辨认 声学模子 的区分性练习 准则和模子 自顺应 方法被提出以后,在很长一段内语音辨认 的 发展是比力 迟钝 的,语音辨认 错误率的那条线不停 没有显着 的降落 。直到 2006 年 Hinton 提出深度置信网络(DBN),促使了深度神经网络(DNN)研究的复苏。

2009 年,Hinton 将 DNN 应用于语音的声学建模,在 TIMIT 上得到 了当时 最好的结果 。2011 年底,微软研究院的俞栋、邓力两位老师又把 DNN 技能 应用在了大词汇量连续 语音辨认 任务 上,大大低落 了语音辨认 错误率。以后 以后基于 DNN 声学模子 技能 的研究变得非常 火热。微软客岁 10月发布的 Switchboard 语音辨认 测试中,更是取得了 5.9%的词错误率,第一次实现了和人类一样的辨认 程度 ,这是一个汗青 性突破。

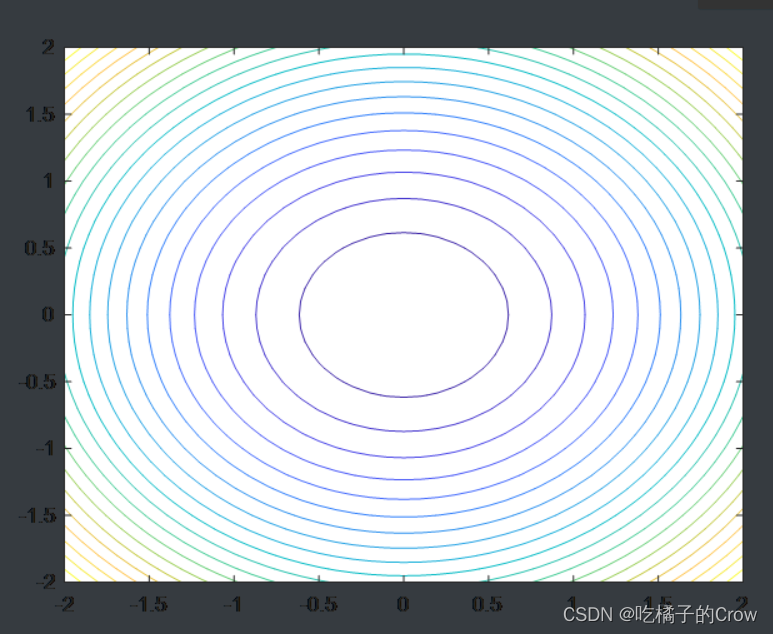

那么什么是 DNN 的?着实 标准 的 DNN 一点也不秘密 ,它和传统的人工神经 (ANN)在布局 上并没有本质的区别,只是 ANN 通常只包罗 一个隐层,而 DNN 则是通常包罗 至少 3 层以上的隐层,通过增长 隐层数量 来举行 多层的非线性变更 ,大大的提拔 了模子 的建模本领 。

这是基于 DNN 的语音辨认 体系 框架,相比传统的基于 GMM-HMM 的语音辨认 体系 ,其最大的改变是采取 DNN 更换 GMM 模子 对语音的观察概率举行 建模。

相比传统 GMM 模子 我以为 有两点黑白 常紧张 的:

1.利用 DNN 不必要 对语 音数据分布举行 假设。

2. DNN 的输入可以是将相邻语音帧拼接形成的包罗 时序布局 信息的矢量。

当时 练习 DNN 的广泛 做法是先举行 无监督 的预练习 ,而后举行 有监督 的调解 ,厥后 人们发现当数据量非常大的时间 无监督 的预练习 并不是须要 的,固然 这是后话了。

促使 DNN 的研究在当时 重新鼓起 尚有 一个非常紧张 , 而且 我个人以为 是最核心 的因素,就是盘算 本领 的提拔 。

从前 要在 CPU 上练习 DNN 黑白 常慢的,做一个实行 大概 必要 好几周乃至 几个月,这是不能忍受的, 随着 GPU 的出现这种环境 发生了变革 ,GPU 非常得当 对矩阵运算举行 加快 ,而 DNN 的练习 终极 都可以被拆解成对矩阵的操纵 ,两者天然 调和 。

而今随着 GPU 技能 的不绝 发展和进步,我们可以或许 练习 数据量更大、网络更深、布局 更复杂的模子 ,这才有了深度神经网络技能 的敏捷 发展。

LSTM 模子 信托 各人 都不陌生 ,它一种特别 的循环神经网络(RNN)。语音 辨认 原来 就是一个时序建模题目 ,以是 非常适实用 RNN 来举行 建模。

但是简单 的 RNN 受限于梯度爆炸和梯度消散题目 ,比力 难以练习 。而 LSTM 通过输入门、 输出门和忘记 门可以更好的控制信息的活动 和转达 ,具有黑白 时影象 本领 ,并在 肯定 程度 上缓解 RNN 的梯度消散和梯度爆炸题目 。固然 它也有不敷 之处,盘算 复杂度相比 DNN 大幅增长 ,而且 由于递归毗连 的存在难以很好的并行。

BLSTM 进一步提拔 了该类模子 的建模本领 ,相比 LSTM 还思量 了反向时序 信息的影响,也即“将来 ”对“如今 ”的影响,这在语音辨认 中也黑白 常紧张 的。

固然 这种本领 的代价就是模子 盘算 复杂度进一步加大,而且 通常必要 整句举行 训 练:GPU 显存斲丧 增大-并行度低落 -模子 练习 更慢,别的 在实际 应用中还存在及时 性题目 。

CTC 技能 在已往 的一段时间内也非常的火热,起首 要阐明 的是 CTC 并不是模子 的变革 ,而是优化的目标 函数发生了改变,DNN、LSTM、CNN 都可以和 CTC 相连合 。

传统的深度神经网络声学模子 的练习 过程必要 先对练习 数据文本序列做 Alignment 得到分类的“硬讯断 ”,之后以这种“硬讯断 ”的分类为目标 练习 神经网络,网络优化的目标 并不是终极 要辨认 的结果 。和传统的深度神经网络声 学模子 相比 CTC 的优化目标 是一种所见即所得的优化目标 ,你要练习 的目标 就 是你想要得到的结果 。

传统的深度神经网络声学模子 建模单位 通常是 state 级的,而 CTC 的建模单位 则是 phone 一级乃至 是 character 的,state 级反而不好 ,这种建模粒度的 变革 带来一个长处 就是语音数据的冗余度增长 了,相邻的语音帧原来 就会很像并 大概 来自于同一个 phone,那么如今 就不必要 这么多帧数据来建模一个句子。

通过拼帧降采样的方法可以低落 数据的总帧数,在不影响辨认 正确 率的环境 下加快 网络盘算 的速率 。CTC 的另一个非常紧张 的贡献是引入了“Blank”空缺 ,空缺 的 引入克制 了易肴杂 帧的“逼迫 ”对齐。而且 使得练习 后的网络输出出现 “尖峰”状 态,大段的 Blank 使得解码时通过 beam 的机动 调解 ,可以加快 解码速率 。

语音辨认 开源平台先容 与对比

语音辨认 范畴 有非常多的开源工具,传统的语音辨认 开源工具像 CMU SPHINX 体系 ,是基于统计学原理开辟 的第一个“非特定人连续 语音辨认 体系 ”; 剑桥语音辨认 组推出的 HTK 工具包是 GMM-HMM 期间 最为盛行 的语音辨认 工具,我刚打仗 语音辨认 就是从 HTK 开始的。

几年前推出的 kaldi 严格 来讲并不十 分“传统”,也是比力 新而且 在不绝 更新的开源工具,如今 应该也是利用 人数最多的语音辨认 开源工具。

近两年来很多 深度学习开源框架涌现了出来,像 Theano、 CNTK、TensorFlow 等,接下来我会对传统的语音辨认 工具和新的深度学习开源框架做一个对比,那么我就简单 从几个我比力 关心的维度来抛砖引玉看看 kaldi、CNTK 和 TensorFlow 的异同。

在拓扑底子 方面,kaldi 的 nnet1 和 nnet2 是以层计划 为底子 的,也即当你新增长 一种神经网络层时必要 本身 界说 它的布局 ,都有哪些变量,正向怎么算, 反向偏差 怎么传播 等等,而且 过于复杂的毗连 方式很难支持。

而 kaldi 的 nnet3 和 CNTK 以及 TensorFlow 都是以图布局 为底子 的,通过设置 文件实现对网络毗连 方式的界说 ,数据就像流水一样在你界说 的网络图中游走,并本身 实现偏差 的 反向传播 ,它的长处 是你可以专注网络拓扑布局 的计划 ,而不消 为网络盘算 的细 节而费心,特别 是偏差 的反向传播 。

但这也带来一个题目 ,尤其是对初学者而言, 会造成只是在计划 网络长成什么样子,但并不清楚 此中 的实现细节。初学者最很多 多少 推推公式,对打下一个坚固 的底子 绝对有长处 。

在语音辨认 别的 工具支持方面,kaldi 有全套的语音辨认 工具,包罗 解码器、 创建 决定 树、GMM 练习 等等,而 CNTK 和 TensorFlow 在这方面并没有特别 的支持,值得一提的是 CNTK 里提供了把 kaldi 数据处理 惩罚 成为 CNTK 数据格式的工具,使的用 kaldi 的人也可以很快上手 CNTK,各人 不妨试一下。

末了 一个我比力 关心的因素就是是否支持多机多卡,由于 随着数据量和模子 复杂度的不绝 攀升,仅仅用一个 GPU 很难满意 模子 练习 的必要 ,必须利用 多个 GPU 来加快 练习 。在这方面貌 前 kaldi、CNTK、TensorFlow 都已经支持。

末了 我的发起 是对于语音辨认 的初学者和低年级的研究生来讲,用 kaldi 入门学习算法和实践理论知识是比力 好的选择,对于高年级研究生和具有肯定 年限 的从业职员 来讲,就看本身 的喜好 了,各人 都是殊途同归,工具不是决定性的, 数据、算法和模子 才是。

二、前沿神学模子 的技能 盼望

接下来先容 一下 Deep CNN 技能 、Residual/Highway 网络技能 和粗粒度建模单位 技能 。客岁 有多家机构都推出了本身 的 Deep CNN 模子 ,像 IBM、微软等,我这里以 IBM 的 Deep CNN 为例,一起探究 一下到底哪些关键因素使得 Deep CNN 可以或许 取得这么好的结果 。

着实 CNN 被用在语音辨认 中已经不是一天两天了,在 12、13 年的时间 Ossama Abdel-Hamid 就将 CNN 引入了语音辨认 中。

当时 候的卷积层和 pooling 层是瓜代 出现的,而且 卷积核的规模是比力 大的,CNN 的层数也不是特别 的多, 重要 是用来对特性 举行 进一步的加工和处理 惩罚 ,使其能更好的被用于 DNN 的分类。

厥后 随着 CNN 技能 在图像范畴 的发展,环境 渐渐 出现了变革 ,人们在图像范畴 的研究中发现多层卷积之后再接 pooling 层,减小卷积核的尺寸可以使得我们可以或许 练习 更深的、结果 更好的 CNN 模子 。相应的方法被鉴戒 到了语音辨认 中,并 根据语音辨认 的特点举行 了进一步的优化。

IBM 的研究职员 在 16 年的 ICASSP 上发表文章,称利用 3x3 的小卷积核和 多层卷积之后再接 pooling 的技能 可以练习 出 14 层(包罗 全毗连 )Deep CNN 模子 。

在 Switchboard 数据集上相比传统的 CNN 利用 方法可以带来相对约 10.6%WER 降落 。小尺寸的卷积核和多层卷积之后再接 pooling 的技能 是使 Deep CNN 可以或许 乐成 的关键点。

接下来先容 一下 Residual/Highway 网络以及它们如今 在语音辨认 中的应用环境 。

Residual 网络会这么着名 得益于 MSRA 的 152 层让人“疯狂”的深度神经网络,依附 着它 MSRA 在 2015 ImageNet 盘算 机辨认 挑衅 赛中以绝对上风 得到 图像分类、图像定位以及图像检测全部三个重要 项目标 冠军。

在公开的论文当中, 作者具体 解读了他们的“心路进程 ”。

研究职员 发如今 深度神经网练习 过程中总是会出现”Degration Problem”,即当网络深度到达 肯定 程度 以后,随着网络深度的 增长 training error 将不降反增,而且 这不是由于过拟合引起的。

一样平常 来讲我们 以为 一个浅层网络 A 叠加几层成为网络 B,假如 叠加的几层权重都是单位 矩阵, 那么 B 的性能至少不会比 A 差,但实际 并非云云 ,网络本身 很难学习到这种变更 。

而相比与学习目标 函数而言残差更轻易 学习,于是提出了一种 residual learning 的布局 ,增长 了一个越层的短毗连 。我的明白 是这种短毗连 一方面克制 了前向盘算 中非线性变更 对数据的太过 加工,另一方面在偏差 反向传播 时通过直 连通路,可以让偏差 有路径直接回传,克制 梯度消散。

约莫 稍早,Srivastava 在 arxiv 上传了他的 Highway 网络工作,在 Highway 网络中一个隐层节点的输出不再单单是输入通过非线性变更 后的数值,而是变成 了通过 Transform gate 和 Carry gate 对非线性变更 后的数值和输入举行 加权得到的结果 。Residual 网络可以被当作 是 Highway 网络的 一种不额外增长 参数量 的特例。

Residual/Highway 网络这么有结果 ,语音辨认 范畴 的研究职员 固然 也会关注并利用 。我来举几个例子,在“Highway Long Short-Term Memory RNNs for Distant Speech Recognition”中作者提出 Highway LSTM 布局 ,引入了一种 carry gate,Carry gate 控制当前层 cell 状态盘算 有多少来自于前一层的 cell 状态, carry gate 的盘算 又取决于当前层的输入、当前层前一时候 的 cell 状态和前一层 当前时候 的 cell 状态。通过这种模子 布局 实现了信息在模子 内部更好的跨层活动 。

在 ”Multidimensional Residual Learning Based on Recurrent Neural Networks for Acoustic Modeling”中作者将 Residual 的概念应用到 LSTM 模子 中,并在 TIMIT 和 HKUST 两个数据集上验证了实行 结果 。

在 ”Renals.Small-footprint Deep Neural Networks with Highway Connections for Speech Recognition”中作者对比了 Residual DNN 和 Highway DNN 在语音辨认 上的结果 ,得到的结论是:” residual networks are more powerful to train deeper networks compared to plain DNNs, particular with ReLU activation functions which reduce the optimisation difficulty. However, highway networks are more flexible with the activation functions due to the two gating functions that control the follow of information.”

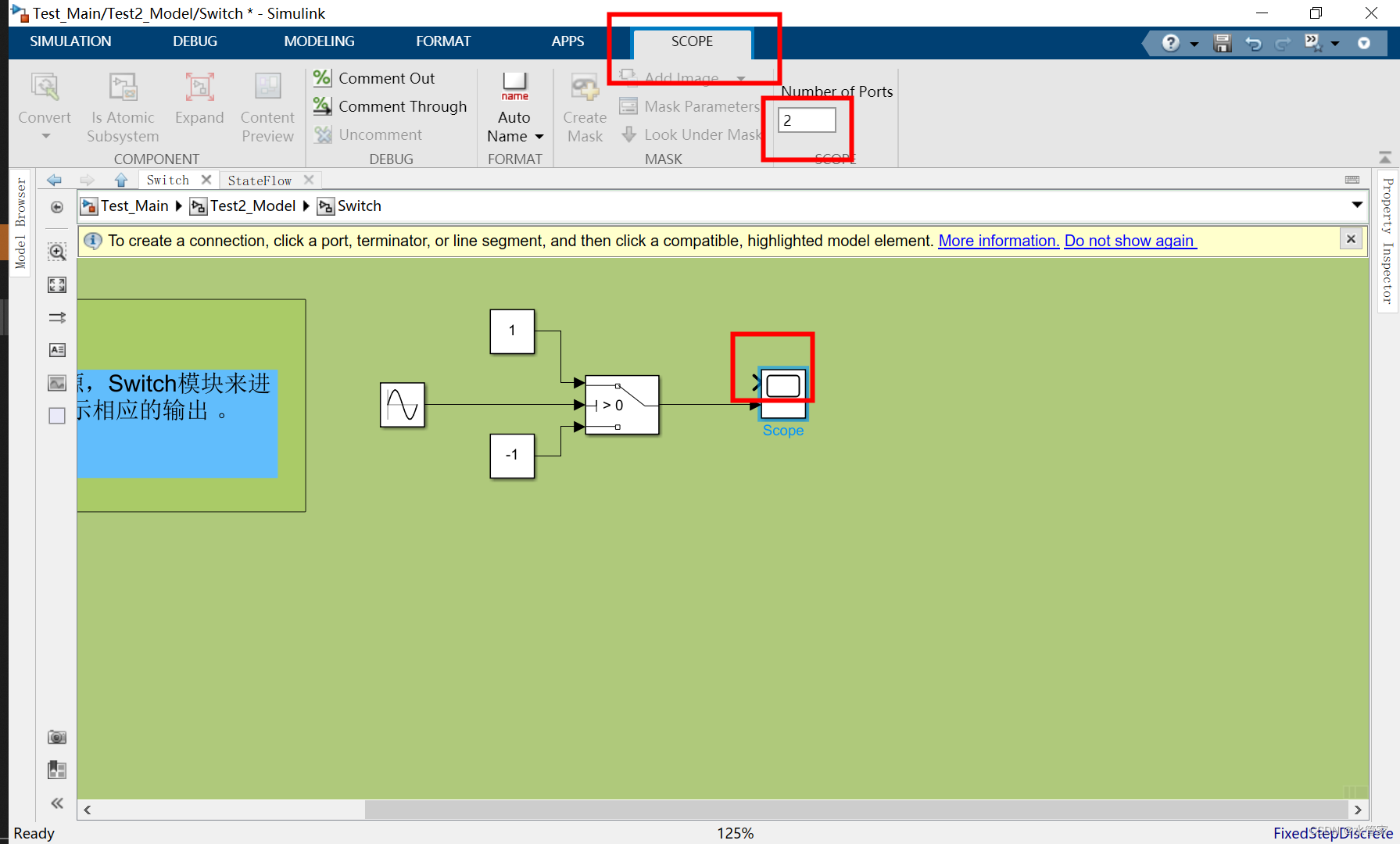

下面是粗粒度建模单位 技能 ,Low frame rate 技能 我会放到背面 连合 阿里巴巴的声学模子 技能 举行 阐明 ,先来看一下 Chain 模子 。Chain 模子 是 kaldi 的作者 Daniel Povey 近期力推的工作,它利用 的也是 DNN-HMM 架构,表中我列出了 chain 模子 和传统的神经网络声学模子 建模的差别 点。

在建模单位 方面,传统神经网络声学模子 的建模单位 一样平常 是 3 状态大概 5 状态的 CD phone,而 chain 模子 的建模单位 则是 2 状态,此中 sp 是最重要 用来表征该 CD phone 的状态,而 sb 则是该 CD phone 的“Blank”空缺 ,空缺 的概念 着实 和 CTC 中的很相似,只是在 chain 模子 中每一个建模单位 都有本身 的空缺 。

在练习 方法上,传统神经网络声学模子 必要 先举行 Cross-Entropy 练习 ,后举行 区分性准则练习 。而 chain 模子 直接举行 Lattice-Free MMI 练习 ,固然 厥后 还可 以接着举行 区分性准则练习 ,但是从如今 的报道来看,这部分 的提拔 是比力 小的。

在解码帧率方面由于 chain 模子 利用 的是拼帧然后降采样的方法,解码的帧率只有传统神经网络声学模子 的三分之一,而辨认 正确 率方面相比传统模子 会有非常显着 的提拔 。 总结一下我以为 将来 深度神经网络声学模子 重要 有三个发展方向。

1.更 Deep 更复杂的网络

雷同 MSRA152 层 ResNet 的技能 ,固然 以如今 的盘算 本领 在语音辨认 的实际 应用中这种复杂网络布局 的模子 临时 还不能落地,但是连续 不绝 的研究和探索可以为我们明白 我们积极 的方向和本领 所能到达 的上界。

2. End to End 的辨认 体系

End to End 的辨认 系同一 直是比年 来比力 火的研究方向,如 CTC、 Attention 等都是在这方面非常故意 义的工作,在海量规模的语音数据上 创建 盘算 速率 快、辨认 正确 率高的 End to End 的辨认 体系 会是将来 的 一个紧张 课题。

3. 粗粒度的建模单位 state-phone-character

粗粒度建模单位 的技能 对于加快 语音辨认 的解码速率 具有非常紧张 的 意义,而反过来解码速率 的提拔 又可以让利用 更深、更复杂神经网络建 模声学模子 成为大概 。

三、阿里巴巴的语音辨认 声学模子 技能

末了 分享一下阿里巴巴团队在语音辨认 声学模子 技能 方面的一些工作。

在工业界做语音辨认 ,数据量黑白 常巨大 的,上万小时的语音数据是再正常 不外 的,面对 云云 巨大 的数据量,利用 单机单 GPU 大概 单机多 GPU 举行 模子 的练习 是远远不能满意 需求的,必须具有多机多 GPU 举行 模子 练习 的本领 。

我们利用 的基于 Middleware 的多机多卡方案。GPU Middleware 提供了 API 接口使得我们可以通过对练习 工具(kaldi、caffe 等)的简单 修改实现并行练习 。而且 可以自主管理任务 队列、数据分发、通讯 、同步等,是我们可以或许 更多的专注于算法本身 。采取 Master-slave 模式,支持 MA / SGD / ASGD 等。

这是 Model Averaging 的一个示例:

表格里给出的是在 5000h 小时练习 数据环境 下练习 DNN 模子 的加快 结果 , 可以看到利用 8 个 GPU 的环境 下约莫 可以取得 7.2 倍的加快 ,利用 16 个 GPU 的环境 下约莫 可以取得 14.3 倍的加快 。我们如今 利用 的是 Latency-control BLSTM 模子 ,这内里 有从 BLSTM 到 CSC-BLSTM 再到 LC-BLSTM 的发展进程 。

我们知道 BLSTM 可以有效 地提拔 语音辨认 的正确 率,相比于 DNN 模子 ,相对性能提拔 可以到达 15%-20%。

但同时 BLSTM 也存在两个非常紧张 的题目 :

1. 句子级举行 更新,模子 的收敛速率 通常较慢,而且 由于存在大量的逐帧 盘算 ,无法有效 发挥 GPU 等并行盘算 工具的盘算 本领 ,练习 会非常耗时;

2. 由于必要 用到整句递归盘算 每一帧的后验概率,解码耽误 和及时 率无法 得到有效 包管 ,很难应用于实际 服务。对于这两个题目 ,前 MSRA lead researcher,如今 已经是阿里巴巴 iDST 语 音团队负责人的鄢志杰和他当时 在微软的练习 生一起起首 提出 ContextSensitive-Chunk BLSTM ( CSC-BLSTM)的 方法加 以办理 。

而以后 文献 (Zhang2015, MIT)又提出了 Latency Controlled BLSTM(LC-BLSTM)这一改进版本,更好、更高效的减轻了这两个题目 。我们在此底子 上采取 LC-BLSTM-DNN 肴杂 布局 共同 多机多卡、16bit 量化等练习 和优化方法举行 声学模子 建模。完成了业界第一个上线的 BLSTM-DNN hybrid 语音辨认 声学模子 。

这两张是 LC-BLSTM 的表示 图,练习 时每次利用 一小段数据举行 更新,数据由中心 chunk 和右向附加 chunk 构成,此中 右向附加 chunk 只用于 cell 中心 状态的盘算 ,偏差 只在中心 chunk 上举行 传播 。时间轴上正向移动的网络,前一 个数据段在中心 chunk 竣事 时的 cell 中心 状态被用于下一个数据段的初始状态, 时间轴上反向移动的网络,每一个数据段开始时都将 cell 中心 状态置为 0。

该方法可以很洪流 平 上加快 网络的收敛速率 ,并有助于得到更好的性能。解码阶段的数据处理 惩罚 与练习 时根本 雷同 ,差别 之处在于中心 chunk 和右向附加 chunk 的维 度可以根据需求举行 调治 ,并不必须与练习 采取 雷同 设置 。

进一步,我们又在 LC-BLSTM 上举行 了改进,起首 提出一种改进的 FABDIBLSTM 模子 ,它和 LC-BLSTM 的差别 在于时间轴上反向移动的网络,cell 中心 状态是由 feed-forward DNN 盘算 得到的,而不是原来采取 的递归方式,如许 在 尽大概 包管 辨认 正确 率的同时,低落 了模子 的盘算 量。

我们还提出一种改进的 FABSR-BLSTM 方法,用简单 RNN 更换 时间轴上 反向移动的 LSTM,以加快 这部分 的盘算 速率 。

表内里 给出的是我们的实行 结果 ,在 Switchboard 数据集上的实行 表明在丧失 少量精度的环境 下,我们的改进版模子 相比标准 的 LC-BLSTM 可以取得 40%- 60%的解码加快 。这部分 工作已经被 ICASSP 2017 吸取 ,即将于本年 三月份发表。

Low frame rate(LFR)是我们上线的又一新技能 ,LFR 是在 Interspeech 2016 集会 会议 上由谷歌的研究职员 提出的,在论文中研究职员 宣称 CTC 技能 只有在 4 万 小时以上的数据量下才有更好的结果 ,而 LFR 通过利用 单状态的 CD-Phone、 拼帧并降帧率、soft label、CE 初始化、Output Delay 等技能 可以让传统神经网 络辨认 模子 取得和 CTC 近似或更好的结果 。

我们鉴戒 了论文中的方法并将其乐成 应用在 LC-BLSTM 上,在我们的一个上万小时数据的任务 上。

LFR-LC-BLSTM 可以取得和 LC-BLSTM 差不多的辨认 错误率,而且 有约 3.6 倍的解码加快 。据我们所知(to the best of our knowledge), 我们也是如今 业界唯逐一 家落地 LFR 技能 的公司。

在模子 的鲁棒性方面,我们也做了非常多的工作。模子 的鲁棒性不停 是困扰 业界和研究职员 的一个题目 ,比如 用安静环境 下的语音数据练习 的模子 在噪声环境 下辨认 正确 率就很差,用消息 播报的语音数据练习 的模子 去辨认 豪情 的体育讲授 ,辨认 正确 率也会很差。

那么怎样 降服 差别 的信道、噪声、应用场景的差别 , 使声学模子 具有更好的鲁棒性呢,最好的办法固然 是网络 更多真实场景下的语音 数据,但是假如 一时之间做不到呢?

怎么利用 现有的语音数据去尽大概 的提拔 模 型的噪声鲁棒性?能不能利用 现有数据去“造”和目标 场景很雷同 的数据?

这是一个很故意 思的研究课题。算法层面的改进这里临时 不提,说一下我们在“造”数 据上的一些工作,我们计划 了一套完备 的数据分析、数据筛选和数据加工流程。

从应用场景分析开始,我们会去分析信道环境 、噪声环境 、语境环境 等等。然后根据对应用场景的分析主动 筛选得当 的练习 数据。再根据差别 的场景环境 , 举行 加噪、加快 语速等处理 惩罚 。末了 练习 模子 举行 测试,再根据对结果 的分析反馈我们应用场景的分析。

这一整套流程开始时由人为计划 的,如今 正渐渐 往主动 化流程上推,依托阿里 MaxCompute 高效盘算 平台我们可以快速的完成海量数据的加工处理 惩罚 ,这大大解放我们的算法职员 ,让各人 有更多的履历 投入到技能 上的优化,而不是为数据烦恼。 末了 是我们语音辨认 技能 应用的一些案例,像是内部的智能质检和智能电话 客服,阿里云年会上及时 语音辨认 挑衅 金牌速记员。

末了 是我们语音辨认 技能 应用的一些案例,比如 阿里巴巴内部的智能质检和智能电话客服,从客岁 开始,阿里团体 与蚂蚁客服每接听一个电话,都会立即 启动一个叫风语者的体系 ,它就是主动 语音辨认 技能 ,将语音变化 成 笔墨 ,千分之三的人工抽检可以刹时 升级为100%的主动 质检。除此应用场景之外,阿里YunOS、阿里小蜜以及手淘,如今 都已经应用到阿里云的语音辨认 体系 。 阿里云在 2016年 会上公开展示及时 语音辨认 技能 ,并现场挑衅 天下 速记大赛亚军得主。据现场终极 评测,呆板 人在正确 率上以 0.67%的薄弱 上风 克服 第50 届国际速联速记大赛环球 速记亚军姜毅。 对外服务上我们开放了智能语音交互的本领 (data.aliyun.com),为企业在多种实际 应用场景下,赋予产物 “能听、会说、懂你”式的智能人机交互体验。 在法庭庭审方面,我们利用 语音辨认 技能 ,将庭审各方在庭审过程中的语音直接变化 为笔墨 ,供各方在庭审页面上查察 ,书记员简单 或不消 调解 即可作为庭审笔录利用 。 各人 在眼见 直播平台上看云栖大会直播时,上面的及时 字幕背后用的也是我们本身 的语音辨认 技能 。

参考文献

内容转载自公众号

AI科技批评

相识 更多

琼ICP备2025060053号

琼ICP备2025060053号

发表评论

共有[ 0 ]人发表了评论