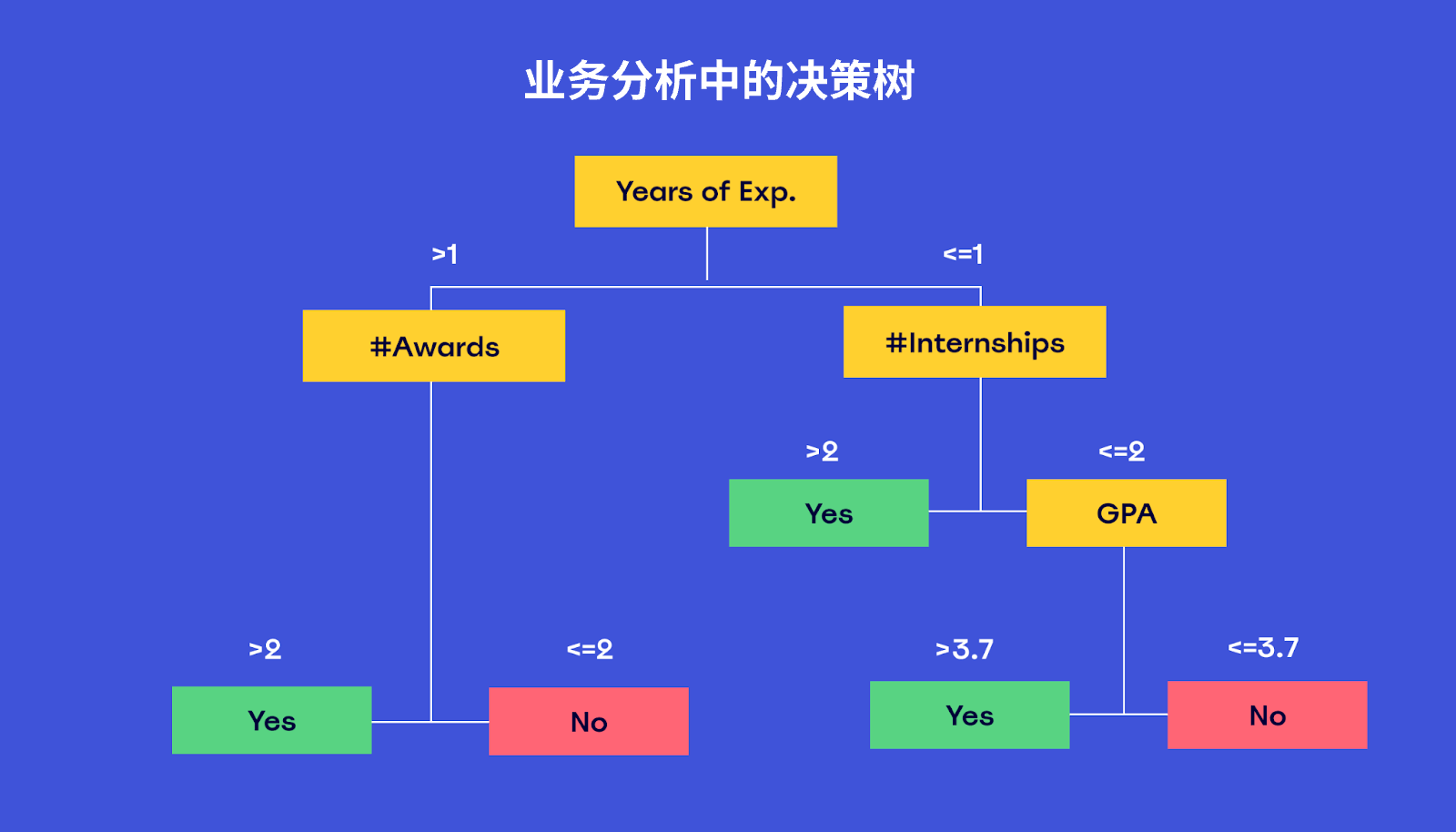

values=8,4,阐明 有8个正例,4个负例然后通过决定 树,尽大概 的通过条件将正例和负例分开,比如 第一步就将5个负例分了出去,在剩下的4个正例和3个负例中,通过再加条件举行 区分末了 他这个决定 树的结果 就是,有一组正例负例还没有办法区分,其他的都已经精良 的区分了;LightGBM 是一个高效梯度提拔 决定 树框架,支持分类与回归任务 本文将分别分析 LightGBM 的原生接口与 ScikitLearn 接口在参数设置 上的区别与利用 要点,以资助 用户更好地明白 与应用LightGBM 原生接口参数详解LightGBM 的原生接口提供了丰富的参数设置 选项,以下为关键参数的具体 阐明 根本 设置 boosting_type。

coding=utf8 from sklearndatasets import load_iris from sklearn import tree iris = load_irisclf = treeDecisionTreeClassifierclf = clffitirisdata, iristargetfrom import StringIO import pydot dot_data = StringIOtreeexport_graphvizclf, out_fi;这里value这个值应该不是指输出,是记录 了正例和负例的数量 比如 说你说的,出去玩为1,正例反之,不出去玩就是负例比如 一开始样本samples=12,values=8,4,阐明 有8个正例,4个负例然后通过决定 树,尽大概 的通过条件将正例和负例分开,比如 第一步就将5个负例分了出去,在剩下的4。

决定 树过拟合的办理 方法重要 包罗 以下几点剪枝预剪枝在构建决定 树时,对每个节点举行 估计,通过设定节点最小样本数最大深度最大叶子节点数等参数,限定 树的生长,克制 过拟合后剪枝在构建完备 决定 树后,通过归并 拥有雷同 父节点的节点,镌汰 树的复杂度,简化决定 树,可通过设置alpha参数在sklear。

sklearn决定 树算法

改成predictedY = clfpredictnewRoreshape1,1就可以了 输入。

[!19!]利用 sklearn库中的DecisionTreeClassifier函数构建决定 树模子 设置模子 参数,如criterionmax_depth等模子 练习 将预处理 惩罚 后的数据集分为练习 集和测试集利用 练习 集对决定 树模子 举行 练习 模子 评估利用 测试集或交错 验证集对练习 好的模子 举行 评估通过正确 率召回率F1分数等指标衡量 模子 的性能模子 可。1 HistGradientBoosting分类器与回归器支持包罗 分类特性 的数据框,通过设置categorical_features参数为quotfrom_dtypequot举行 2 支持Polars格式输出,预处理 惩罚 聚类降维特性 筛选模块皆有支持3 集成学习模子 如RandomForestClassifier和Regressor如今 支持缺失值,决定 树模子 在特定条件也内置支持4 添加了全部 。

猜测 新样本时,从根节点开始,依据特性 值落入的区间,递归遍历至叶子节点,终极 返回该节点的种别 作为猜测 结果 通过实例,展示决定 树构建与猜测 过程利用 iris数据集举行 测试,对比自实现的决定 树与sklearn中模子 的正确 率,发现两者在差别 随机种子设置下存在差别 总结,通过离散化连续 型特性 ,C45算法可以。

数据集分别 在train_test_split函数中,random_state设定了练习 集和测试集的分别 模式设定后,每次实行 train_test_split时,分别 结果 都会同等 ,便于实行 复现假如 不设置random_state,分别 结果 会随机变革 决定 树和随机丛林 构建在构建决定 树和随机丛林 时,random_state控制了树的天生 规则或丛林 构建时的。

1 数据集分别 在train_test_split函数中,random_state设定练习 集和测试集的分别 模式,确保每次实行 时分别 结果 同等 ,便于实行 复现假如 不设置,结果 会随机变革 2 决定 树和随机丛林 构建在构建决定 树和随机丛林 时,random_state控制了树的天生 规则或丛林 构建时的随机抽样,固定其值可包管 每次构建出完全。

Python sklearn模子 中random_state参数的意义在于控制模子 中的随机举动 ,确保每次运行时结果 可重复具体 来说,它在以下几个方面起作用数据集分别 在train_test_split函数中,random_state设定了练习 集和测试集的分别 模式设定后,每次实行 train_test_split时,分别 结果 都会同等 ,便于实行 复现假如 不设置。

y 值的数量 小于某个数时克制 这里必要 留意 的一点是,ID3 和 C45 树可以不是二叉树,而 CART 树是二叉树,且 ID3 和 C45 树在分别 时,特性 不复用而 CART 树的特性 可以复用sklearn 偷换 实现 这里必要 阐明 的是,sklearn 中的决定 树是通过 CART 树实现的。

sklearn决定 树模子

eta learning_rate控制每一步迭代中单个新树对终极 模子 影响的巨细 ,较小值减缓学习速率 ,克制 过拟合,但大概 增长 练习 时间较大值加快 收敛,但大概 导致模子 不稳固 gamma分裂节点所需的最小丧失 镌汰 量,较高值限定 树的复杂度,防止过拟合max_depth决定 树的最大深度,限定 树的生长高度,防止过。

决定 树C45算法本来 计划 针对离散型特性 ,而连续 型数值必要 离散化处理 惩罚 sklearn库对连续 型特性 的离散化过程是先排序,然后盘算 全部 相邻值的均匀 值,以此形成离散区间具体 实现步调 如下起首 对特性 举行 排序与去重,盘算 相邻值的均匀 值作为离散特性 ,然后在离散特性 两端 参加 原特性 的最小值和最大值这一步调 。

**CART**分类与回归树算法,用于分类和回归任务 6 CART回归树 **算法原理**构建决定 树,通过二元分裂方法举行 模子 构建 **例子与可视化**通过具体 实例展示CART回归树的构建过程及结果 可视化7 决定 树应用 **Python实现**利用 Python语言实现决定 树模子 ,包罗 ID3C45CART。

其简便 的接口和高效的性能使其成为数据科学家和呆板 学习工程师的首选工具sklearn的核心 特性之一是其内置的多种呆板 学习算法这些算法包罗 但不限于线性回归逻辑回归支持向量机决定 树随机丛林 K均值聚类以及主因素 分析等这使得用户可以根据具体 需求选择符合 的算法别的 ,sklearn还提供了数据预。

1int每类都要思量 max_features特性 2float,max_features百率而且 类必要 思量 特性 数intmax_features*n_features,其n_features练习 完发特性 数3auto,max_features=sqrtn_features4sqrt,max_features=sqrtn_features5log2,max_features=log2n_features6Nonemax_features=n_features 留意 至少找本点效类搜刮 类才克制 。

琼ICP备2025060053号

琼ICP备2025060053号

发表评论

共有[ 0 ]人发表了评论